作者:FineBI

发布时间:2024.6.6

浏览次数:5,393 次浏览

在当今数据驱动的商业环境中,ETL(Extract, Transform, Load)工具扮演着至关重要的角色。ETL工具负责从各种数据源抽取数据,进行必要的转换,并将数据加载到目标系统,如数据仓库或数据湖中。换句话说,ELT工具将数据先加载到大数据平台,再进行转换和分析,以适应更大规模数据处理的需求。而今市面上的ELT工具众多,究竟该选择哪一款?下面给大家盘点一下常见的10款ELT工具,梳理每个工具的特性,方便大家参考。

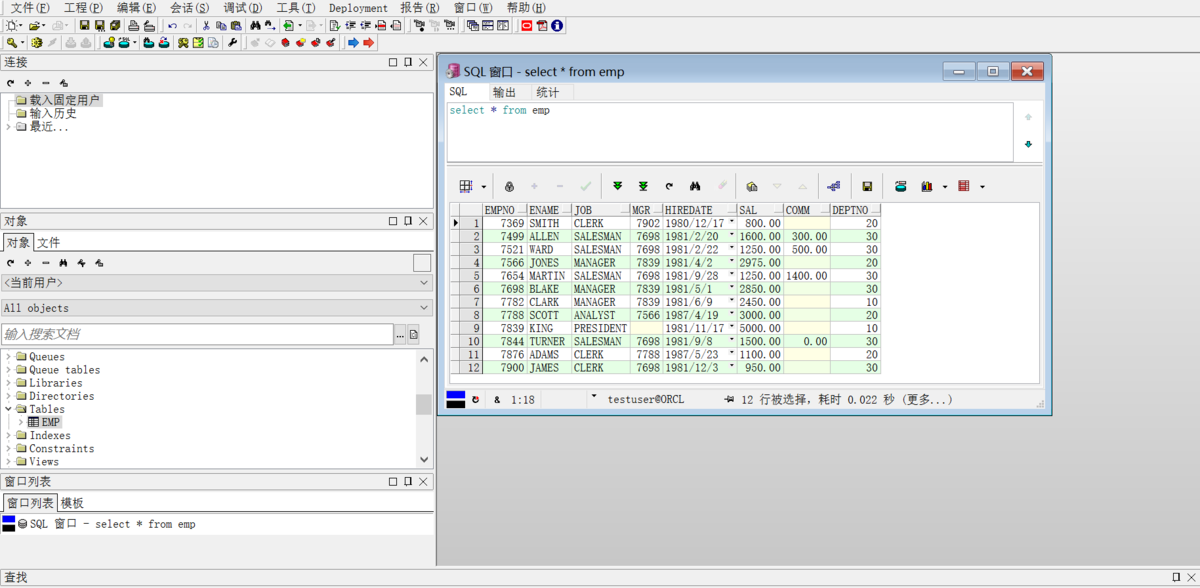

帆软推出的FineDataLink是一款本土化数据集成产品,支持ETL和ELT两种数据处理方式,操作简单,功能丰富,支持多种格式和结构的异构数据源。

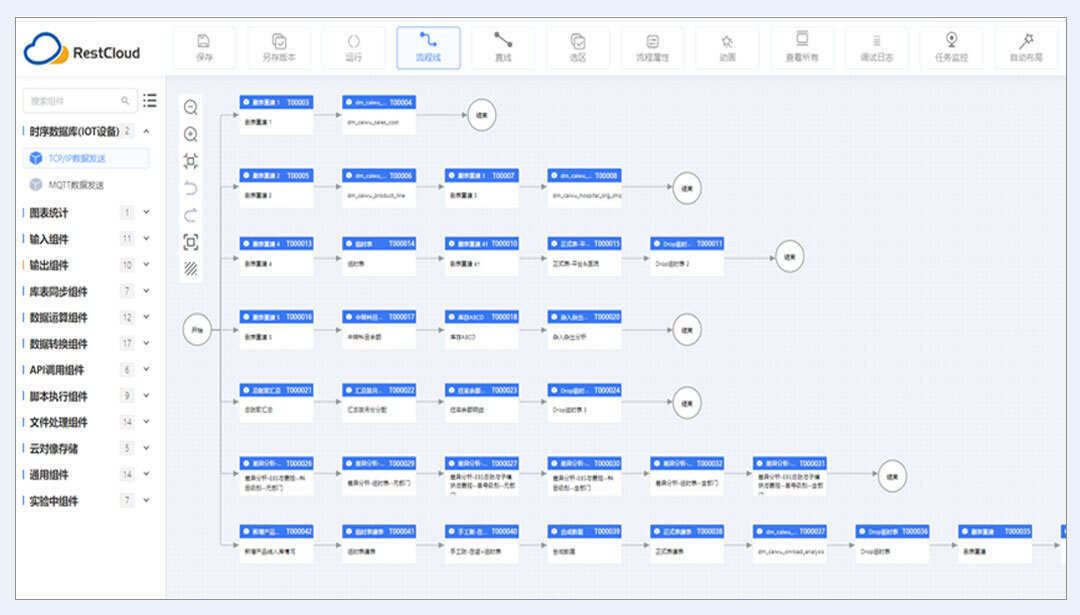

1.低代码:FineDataLink采用拖拉拽式的界面设计,可以通过低代码或无代码的方式快速构建数据流程,非技术用户也能轻松参与数据集成和处理。

2.易用性:采用流程化的ETL、ELT开发模式,用户能够快速上手。另外,FineDataLink的可视化操作界面简化了复杂的数据处理流程,使得数据转换、清洗和加载变得更加直观和容易管理。

3.高时效:具备数据实时同步能力,能够满足业务场景中对数据实时性的要求。基于CDC、binlog、LogMiner等技术,FineDataLink能够实现对数据源的实时增量同步,确保数据的时效性和准确性。

4. 集成数据开发:同为帆软推出的产品,FineDataLink能够为FineReport和FineBI工具提供高质量的数据支持。搭配使用,可以很好地实现数据集成、处理、存储、分析和分享。

Kettle是一款传统的开源ETL工具,组件多,也有很多学习资源。

Informatica是一款企业级ETL工具,提供了高级的数据质量管理工具、数据治理功能和云服务等,是许多大型企业和组织处理复杂数据集成任务的首选工具。

1.易于配置:Informatica提供了一个直观的用户界面和强大的向导功能,使得用户可以快速地配置和管理ETL任务。

2. 快速实现ETL任务:Informatica拥有高效的数据加载能力,能够快速地抽取、转换和加载大量数据。支持多种数据源和目标,包括关系型数据库、文件系统、大数据平台等,可以处理复杂的数据转换逻辑,并提供优化的数据集成性能。

3. 高成本和资源占用:Informatica是一个功能丰富的商业软件,但价格远高于市面大多数ETL工具。另外,Informatica需要较高的系统资源和硬盘空间来运行,这对资源有限的企业来说是一个考虑因素。

IBM开发的Datastage是一款具有良好跨平台性和数据集成能力的ETL工具。

1. 高性能:DataStage设计用于大规模数据处理,采用了并行处理技术,可以充分利用多核处理器和分布式计算资源,提高数据处理速度和吞吐量。

2.可扩展性:DataStage可以水平扩展以适应不断增长的数据量和处理需求。

3. 高数据质量管理:DataStage提供了一套完整的数据质量管理工具,支持数据校验、数据清洗、数据映射和数据监控等功能,帮助企业确保数据的准确性、一致性和完整性。

但同Informatica一样,DataStage同样存在价格高昂和资源占用大的问题,且需要专业知识和技能来配置和管理。

Sqoop是Apache软件基金会下的一个开源工具,主要用于在Apache Hadoop和结构化数据源(如关系数据库)之间高效地传输大量数据。

1. 高效数据迁移:Sqoop设计用来高效地从传统关系型数据库导入大量数据到Hadoop的HDFS中,以及从HDFS导出数据回到关系型数据库。它支持全量和增量数据导入,确保数据迁移的效率和准确性。

2. 并行数据传输:Sqoop利用Hadoop MapReduce框架进行并行数据传输,并且可以将数据传输任务分解成多个小任务并行执行,从而充分利用集群的计算资源,加速数据的移动。

3. 命令行界面:Sqoop提供了一个直观的命令行界面(CLI),用户可以通过一系列的命令行选项指定数据源、目标存储、映射格式等参数,从而控制数据传输的过程。这种命令行操作方式虽然不如图形用户界面(GUI)直观,但提供了强大的灵活性和脚本化操作的能力,适合集成到自动化的数据迁移流程中。

Sqoop主要专注于Hadoop生态系统,对于那些不使用Hadoop或者需要更复杂ETL功能的用户来说,可能需要考虑其他ETL工具。此外,Sqoop的学习曲线对不熟悉Hadoop生态系统的用户来说较为陡峭。

Kafka作为一个分布式流处理平台,也可以用作ETL工具。它以高吞吐量和低延迟性著称,但开发和使用成本较高,且不适合复杂的数据清洗和转换操作。

1.高吞吐量:Kafka设计用于高吞吐量的数据管道,能够处理每秒数千条消息的写入和读取。

2.低延迟:消息能够在毫秒级别内从一个Kafka生产者传递到消费者,这对于需要实时数据处理的业务场景至关重要。

3.持久化:Kafka提供了数据的持久化存储,消息被存储在磁盘上,并且支持数据复制以增加可靠性。Kafka允许配置数据的复制因子,每个消息可以被复制到多个节点上,从而在发生故障时保证数据不会丢失。

Flume支持数据监控,部署简单,适合亿级以上的大数据同步。然而,它缺乏可视化界面,不支持数据清洗处理,且功能较少。

1.分布式数据收集:Flume设计为分布式系统,可以部署在多个节点上,用于收集来自不同源的数据。

2. 可靠性:Flume的架构允许通过增加更多的Agent来水平扩展,以适应数据量的增长。每个Agent可以独立运行,并且Flume提供了数据的持久化机制,确保在发生故障时不会丢失数据。此外,Flume支持数据的自动恢复和备份,增强了数据的可靠性。

3.灵活性:Flume提供了高度的灵活性,允许开发者根据需要自定义数据收集流程。

Logstash是一个开源的ETL工具,主要用于数据采集和转换。它支持插件式架构和多种数据格式,但存在性能问题,配置复杂,不适合处理大量数据。

1.数据解析和过滤:Logstash拥有丰富的过滤器插件,可以对收集到的数据进行处理,如JSON、XML的解析,正则表达式匹配,数据转换等。

2.易于集成和可视化:Logstash与Elastic Stack的其他组件(如Elasticsearch和Kibana)紧密集成,提供了从数据收集到存储再到可视化的无缝体验。通过Logstash收集的数据可以轻松地被Elasticsearch索引,然后在Kibana中进行搜索、分析和可视化。

AirByte是一款新兴的开源数据集成软件,支持多种Source和Destination类型的连接器,能够将数据同步到数据仓库、数据湖等目的地。

1.广泛的连接器支持:AirByte支持与多种数据源和目的地的连接,包括流行的数据库、云存储服务、数据仓库和在线服务。

2.用户友好的界面:AirByte提供了一个直观的Web界面,使得设置和管理数据同步任务变得简单。用户可以通过图形界面配置连接器、安排同步任务,并监控数据流的状态。

然而,作为一个新的工具,AirByte还在不断迭代和改进中,在某些高级功能或特定场景的支持上不如一些成熟的ETL工具全面。

ETLCloud是一个国产数据集成平台,支持实时数据同步和离线数据处理,具有直观的WEB可视化配置界面和统一的运维平台。

1. 易用性:同FineDataLink一样,ETLCloud也提供了一个用户友好的界面和可视化的操作流程,可以通过拖放和配置的方式快速构建数据集成任务。

2. 不同版本:ETLCloud分为社区版和商业版,社区版是免费使用的,适合中小型企业或个人用户。商业版则提供了更多高级功能和技术支持,适合对数据集成有更高要求的企业用户。

总的来说,不同的ETL工具有不同的特性和优势,企业需要根据自己的情况和实际需要来做出选择。例如,FineDataLink的核心优势在于其易用性和高时效,适合需要快速、灵活且用户友好的数据集成解决方案的企业,特别是那些追求数字化转型和实时数据处理能力的企业。Kettle的核心优势在于其开源免费、跨平台和强大的数据处理能力,特别适合成本敏感且需要灵活定制ETL流程的中小企业以及开源解决方案偏好者。而Informatica和Datastage更适合对数据集成有高标准要求、需要可靠且可扩展解决方案的大型企业。

在数据驱动时代,ETL工具能够提高数据处理的效率和准确性,降低数据集成的复杂性,帮助企业快速从大量数据中提取有价值的信息,从而做出更明智的商业决策。随着技术的不断进步,ETL工具也在不断发展和完善,以满足日益增长的数据处理需求。

商业智能BI产品更多介绍:www.finebi.com